Proaktives Agieren durch Monitoring von IT-Infrastruktur

Verfügbarkeit ist eines der zentralen Schutzziele von IT-Infrastrukturen, denn es ist naheliegend, dass nur mit funktionierenden – eben zu Verfügung stehender Technik – gearbeitet werden kann. In Rechenzentren gewährleistet man ein hohes Maß an Verfügbarkeit durch redundante Auslegung sämtlicher Systeme, die ein Glied in der Kette der angebotenen Dienste darstellen.

Hier nun sollte jeder Kunde von Cloud-Dienstleitungen aus Rechenzentren innehalten und sich folgende Frage stellen: Und was ist mit meinem Endgerät, an dem ich dann tatsächlich arbeite? Da sich die zuvor genannte Kette tatsächlich erst bei dem eigentlichen Benutzer schließt, ist diese Frage absolut gerechtfertigt. Wie aber gewährleistet man eine hohe Verfügbarkeit von Endgeräten? Redundanz kann es wohl nicht sein, oder haben Sie stets ein Ersatz-Smartphone griffbereit?

Monitoring – alles Relevante im Blick behalten

Wir haben also die Endgeräte als zu betrachtendes Glied identifiziert. Es gilt nun, dieses gezielt ins Auge zu fassen, um es in seinem laufenden Betrieb effizient zu überwachen.

Wichtig ist, sich die Funktionen klarzumachen, von denen die eigentliche Arbeit abhängt, soll heißen das Relevante herauszufiltern. Relevant sind neben den Hardwarefunktionen auch die Dienste, die Indikatoren für die Lauffähigkeit des Betriebssystems und wichtiger Software sind. Mit diesen Informationen kann das Endgerät nun beobachtet werden, ein Monitoring also.

Monitoring ist praktisch das Ablesen und Prüfen der Vitalfunktionen einer digitalen Arbeitskraft mit dem Ziel, Störungen kritischer Komponenten in ihrer Anbahnung zu erkennen.

Software Agenten als Mess- und Beobachtungsposten

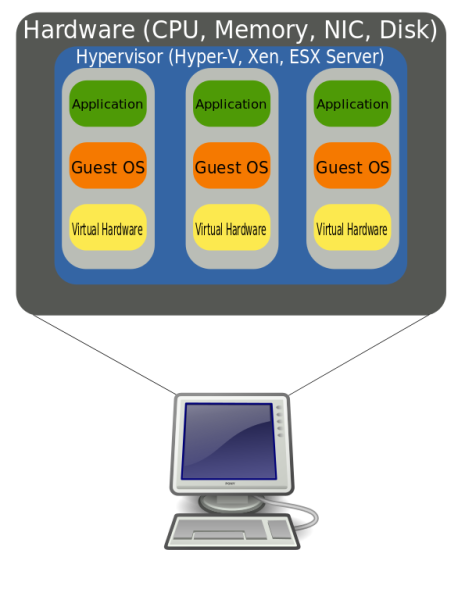

Es ist ersichtlich, dass man zum Monitoring die richtigen Instrumente benötigt. Üblicherweise sind das kleine Softwarepakete, welche passend konfiguriert Daten sammeln und diese über eine sichere Verbindung an ein zentrales Monitoringsystem liefern. Diese Softwarepakete nennt man auch Agenten bzw. Agents.

Das Monitoringsystem hat die Aufgabe, Technikern die diversen gesammelten Informationen der vielen möglichen Systeme graphisch aufbereitet, inklusive einer automatisierten Qualifizierung darzustellen. Erst damit wird es dem Techniker ermöglicht, Abweichungen vom Normzustand zu erkennen und zielgerichtet und schnell zu agieren.

Proaktivität als Mittel der Verfügbarkeitssteigerung

Das Messen und Qualifizieren der vom Agent gesammelten Daten gibt dem Techniker die richtigen Hebel in die Hand, um Störungen vorzubeugen. Droht also zum Beispiel der Speicher eines Endgerätes vollzulaufen und es damit nicht mehr einsatzbereit zu machen, wird dies dem Techniker signalisiert. Dazu hat er zuvor Schwellenwerte definiert, ab der eine Warnung erfolgen soll. Er kann nun schauen, wie er selbst Platz schaffen kann oder den Endanwender mit einem Warnhinweis darum bitten, eventuell unnötige Dateien zu verschieben oder zu löschen.

Noch bevor der Benutzer also mit dem Problem konfrontiert und in seiner Bedienung der Hardware beeinträchtigt wird, wurde es erkannt, bewertet und auch schon aus der Welt geschafft. Dieses Konzept wird als Proaktivität bezeichnet und kann durch Planung und den Einsatz passender Technik umgesetzt werden. Es ermöglicht auch ohne das Hinnehmen eines Ausfalls von redundant ausgelegten Systemen, die Verfügbarkeit der eigentlichen Funktion zu steigern.

Monitoring über kreITiv birgt weitere Mehrwerte

Mit seiner jahrelangen Erfahrung in der Einrichtung und Nutzung von Agent-Software kann Ihnen das Team der kreITiv-IT zur Seite stehen, um Ihre Endgeräte zu betreuen. Darüber hinaus ermöglichen diese uns auch, Fernwartungsaufgaben zu handhaben, Antivirus-Schutz auszurollen und aktuell zu halten sowie auch Datensicherungen anzufertigen. Wir bieten eine vollumfängliche Betreuung, damit Sie sich auf Ihre Arbeit konzentrieren können.